base_model:

- karakuri-ai/karakuri-lm-70b-chat-v0.1

library_name: transformers

tags:

- mergekit

- merge

license: llama2

language:

- ja

karakuri-lm-upscaled-103b-v0.1

karakuri-ai/karakuri-lm-70b-chat-v0.1を自身でフランケンマージし、103bまで拡張したモデルです。ライセンスに関しては元モデルを参照してください。

wolfram/miqu-1-103bと同じマージ手法を用いています。

GGUF版はこちら/Click here for the GGUF version

This is a 103b frankenmerge of karakuri-ai/karakuri-lm-70b-chat-v0.1 created by interleaving layers of karakuri-ai/karakuri-lm-70b-chat-v0.1 with itself using mergekit. Please refer to the original model regarding the license.

Inspired by wolfram/miqu-1-103b.

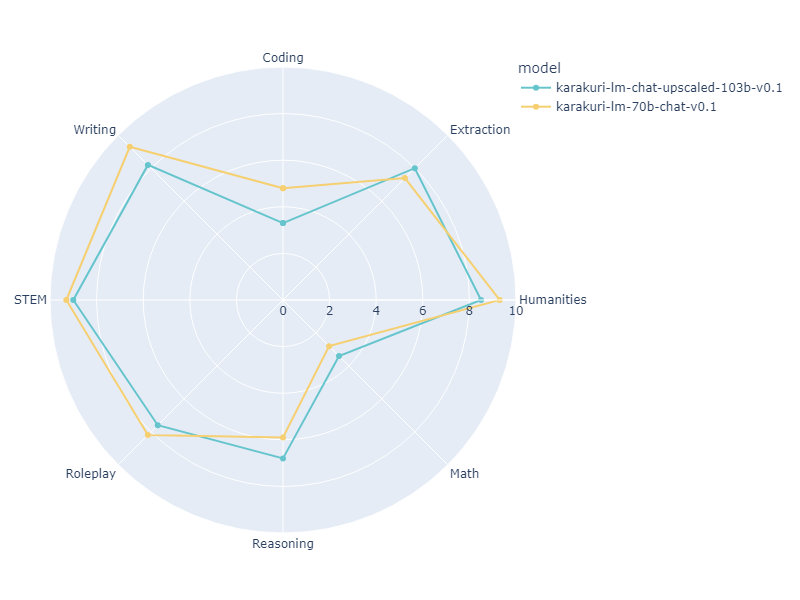

ベンチマーク/Benchmark

ベースとしたkarakuri-ai/karakuri-lm-70b-chat-v0.1と本モデルのjapanese-mt-benchの結果は以下の通りです。 (シングルターン, 4ビット量子化)

平均スコアは低くなっていますが、本モデルの出力は元モデルより長くなっていることが目視で確認され、ベンチマーク設定の関係上出力が途中で途切れてしまい低評価をされることが多い印象でした。(主にHumanitiesやWriting)

こちらを加味すると総合的な性能は同等かあるいはやや高いのではと考察しています。

| Model | Size | Coding | Extraction | Humanities | Math | Reasoning | Roleplay | STEM | Writing | avg_score |

|---|---|---|---|---|---|---|---|---|---|---|

| karakuri-lm-70b-chat-v0.1 | 70B | 4.8 | 7.4 | 9.3 | 2.8 | 5.9 | 8.2 | 9.3 | 9.3 | 7.125 |

| This model | 103B | 3.3 | 8.0 | 8.5 | 3.4 | 6.8 | 7.6 | 9.0 | 8.2 | 6.850 |

ベンチマークに使用したプロンプト

<s>[INST] <<SYS>>

あなたは誠実で優秀な日本人のアシスタントです。

<</SYS>>

{instruction} [ATTR] helpfulness: 4 correctness: 4 coherence: 4 complexity: 4 verbosity: 4 quality: 4 toxicity: 0 humor: 0 creativity: 0 [/ATTR] [/INST]

Merge Details

Merge Method

This model was merged using the passthrough merge method.

Models Merged

The following models were included in the merge:

- ./karakuri-lm-70b-chat-v0.1

Configuration

The following YAML configuration was used to produce this model:

merge_method: passthrough

slices:

- sources:

- model: ./karakuri-lm-70b-chat-v0.1

layer_range: [0, 40]

- sources:

- model: ./karakuri-lm-70b-chat-v0.1

layer_range: [20, 60]

- sources:

- model: ./karakuri-lm-70b-chat-v0.1

layer_range: [40, 80]

dtype: bfloat16